6 Blocs de construction mathématiques : De la géométrie aux quaternions aux bayésiens

Rebecca Stower, Bruno Belzile, and David St-Onge

Table des matières

6.3 Géométrie de base et algèbre linéaire

6.3.2 Représentation vectorielle/matrice

6.3.3 Opérations vectorielles/matrices de base

6.4 Transformations géométriques

6.4.4 Matrices de transformation homogènes

6.7.2 Population générale et échantillons

6.7.4 Le modèle linéaire général

6.1 Objectifs d’apprentissage

L’objectif à la fin de ce chapitre est de maîtriser les compétences suivantes :

- utiliser des opérations vectorielles et matricielles;

- représenter la translation, la mise à l’échelle et la symétrie dans les opérations matricielles;

- comprendre l’utilisation et les limites des angles et des quaternions d’Euler;

- utiliser des transformations homogènes;

- utiliser des dérivées pour trouver les optimums d’une fonction et linéariser une fonction;

- comprendre l’importance et la définition d’une distribution gaussienne;

- utiliser des tests t et des ANOVA pour valider les hypothèses statistiques

6.2 Introduction

De nombreux domaines de la robotique reposent sur des principes de physique et de statistiques. Bien que ce livre s’efforce d’aborder chaque sujet de manière accessible, la plupart des chapitres supposent une connaissance de base en mathématiques. Les pages suivantes résument une variété étendue de concepts mathématiques, allant de la géométrie aux statistiques. Tout au long de ce chapitre, des exemples de fonctions Python pertinentes seront inclus.

6.3 Géométrie de base et algèbre linéaire

Cette section propose un aperçu succinct, mais non exhaustif, des concepts fondamentaux de la géométrie euclidienne. De plus, elle rappelle certaines opérations d’algèbre linéaire qui sont utiles pour manipuler des éléments dans différentes matrices ou tableaux.

6.3.1 Systèmes de coordonnées

Un système de coordonnées est défini comme un « système permettant de spécifier des points en utilisant des coordonnées mesurées de manière spécifique » [1]. Le plus courant, que vous avez très probablement utilisé dans le passé, est le système de coordonnées cartésien, comme illustré à la Figure 6-1. Dans le cas spécifique de l’espace tridimensionnel (3D), il existe un point d’origine à partir duquel les coordonnées sont mesurées, ainsi que trois axes indépendants et orthogonaux, X, Y et Z. Il est nécessaire d’avoir trois axes qui soient indépendants, mais ils ne sont pas obligés d’être orthogonaux. Cependant, dans la plupart des applications (mais pas toutes), il est préférable d’utiliser des axes orthogonaux pour des raisons pratiques (Hassenpflug, 1995).

Figure 6-1 : Différents systèmes de coordonnées dans l’espace 3D

Il existe des alternatives courantes aux coordonnées cartésiennes qui peuvent être plus appropriées pour certaines applications, comme les coordonnées sphériques et cylindriques.

Dans le premier cas, les coordonnées sont définies par une distance ρ à partir de de l’origine et de deux angles, c’est-à-dire θ et ϕ. Dans ce dernier, qui est une extension des coordonnées polaires en 2D, une distance radiale r, un azimut (angle) θ et une coordonnée axiale (hauteur) z sont nécessaires. Alors qu’un point est défini uniquement avec des coordonnées cartésiennes, ce n’est pas totalement le cas avec des coordonnées sphériques et cylindriques; plus précisément, l’origine est définie par un ensemble infini de coordonnées avec ces deux systèmes, car les angles ne sont pas définis à l’origine. De plus, vous pouvez additionner/soustraire des multiples de 360° à chaque angle et vous vous retrouverez avec le même point, mais des coordonnées différentes. De plus, il est important d’être attentif aux conventions utilisées pour les coordonnées sphériques et cylindriques, car les variables utilisées pour définir les coordonnées individuelles peuvent être inversées selon le contexte et la discipline. Les conventions peuvent différer entre les physiciens, les mathématiciens et les ingénieurs [2].

6.3.2 Représentation vectorielle/matrice

En mathématiques, un vecteur est défini « comme une quantité qui possède à la fois une magnitude et une direction, et est généralement représenté par un segment de droite orienté dont la longueur représente la magnitude et la direction dans l’espace représente la direction » [3]. Cependant, cette définition ne fait pas référence aux composants et aux systèmes de référence que nous rencontrons souvent lorsqu’il s’agit de vecteurs. Il existe en effet une confusion courante entre la quantité physique représentée par un vecteur et sa représentation de la même quantité dans un système de coordonnées à l’aide de tableaux unidimensionnels. Le même mot, vecteur, est utilisé pour désigner ces tableaux, mais vous devez faire attention à bien distinguer les deux. Généralement, une flèche sur une lettre minuscule définit un vecteur, la quantité physique, par exemple [latex]\overrightarrow{a}[/latex], et une lettre minuscule en gras représente un vecteur défini dans un repère, c’est-à-dire avec des composantes, par exemple a. Veuillez noter cependant que les auteurs utilisent parfois des conventions différentes. Dans ce livre, le système de coordonnées utilisé pour représenter un vecteur est indiqué par un exposant. Par exemple, la variable [latex]\mathbf{b}^{S}[/latex] représente l’incarnation de [latex]\overrightarrow{b}[/latex] dans le cadre S, alors que [latex]\mathbf{b}^{\cal T}[/latex] représente l’incarnation de [latex]\overrightarrow{b}[/latex] dans le cadre [latex]\cal T[/latex]. Ils n’ont pas les mêmes composants, mais ils demeurent le même vecteur.

Vecteurs [latex]\overrightarrow{a}[/latex] et [latex]\overrightarrow{b}[/latex] dans un espace euclidien à n dimensions peuvent être affichés avec leurs composants comme

| [latex]\mathbf{a} = \begin{bmatrix}a_1\\a_2\\a_3\\\vdots \\ a_{n-1}\\a_n\end{bmatrix},\quad \mathbf{b} = \begin{bmatrix}b_1\\b_2\\b_3\\\vdots \\ b_{n-1}\\b_n\end{bmatrix}[/latex] | (6.1) |

par exemple, les vecteurs [latex]\overrightarrow{c}[/latex] et [latex]\overrightarrow{d}[/latex] sont illustrés à la Figure 6-2. Comme on peut le voir, deux cadres de référence sont également affichés. Leurs composants dans ces cadres sont

Figure 6-2 : Vecteurs planaires et leurs composants dans différents cadres

import numpy as np # Importation des bibliotheques

# tableaux

a = np.array([1,1]) # vecteur

A = np.array([1,2],

[3,4]) # matrice

De même, les tenseurs sont utilisés pour représenter les propriétés physiques d’un corps (et bien d’autres choses). De manière plus formelle, les tenseurs sont des objets algébriques qui définissent des relations multilinéaires entre différents objets dans un espace vectoriel. Cependant, ne vous attardez pas trop sur la définition mathématique, mais plutôt sur ce que vous connaissez déjà. Vous avez déjà rencontré des tenseurs dans ce chapitre, car les scalaires et les vecteurs (la quantité physique, pas le tableau) sont respectivement des tenseurs de rang 0 et de rang 1 [4]. Par conséquent, les tenseurs peuvent être considérés comme une généralisation des scalaires et des vecteurs. Un exemple de tenseur de rang 2 est le tenseur d’inertie d’un corps rigide, qui représente la distribution de masse à l’intérieur du corps rigide (indépendamment du référentiel utilisé). Pour faciliter les calculs numériques, la représentation d’un tenseur de rang 2 dans un système de coordonnées peut être réalisée à l’aide d’une matrice. Cependant, il est important de ne pas confondre les matrices avec les tenseurs de rang 2. En effet, tous les tenseurs de rang 2 peuvent être représentés par une matrice, mais toutes les matrices ne sont pas des tenseurs de rang 2. En d’autres termes, les matrices ne sont que des boîtes (tableaux) avec des nombres à l’intérieur (composants) qui peuvent être utilisées pour représenter différents objets, parmi lesquels des tenseurs de rang 2. Les matrices sont généralement représentées par des lettres majuscules en gras, par ex. [latex]\mathbf{A}[/latex]. Les matrices, qui ont des composants, peuvent également être définies dans des référentiels spécifiques. Par conséquent, l’exposant pour désigner le cadre de référence s’applique également aux matrices du livre, par exemple, [latex]\mathbf{H}^{\cal S}[/latex] représente une matrice de transformation homogène (on le verra dans la section 6.4.4) défini dans S.

D’autres matrices courantes avec des caractéristiques typiques comprennent :

- la matrice carrée, qui est une matrice avec un nombre égal de lignes et de colonnes;

- la matrice diagonale, qui n’a que des composantes non nulles sur sa diagonale, c’est-à-dire des composantes [latex](1, 1), (2, 2), . . . , (n, n)[/latex];

- la matrice d’identité [latex]\mathbf{1}[/latex], qui représente une [latex](n\times n)[/latex] matrice avec seulement 1 sur la diagonale, les autres composantes étant toutes égales à 0.

6.3.3 Opérations vectorielles/matrices de base

Les vecteurs et les matrices sont des outils mathématiques puissants et polyvalents qui possèdent de nombreuses propriétés et opérations. Nous rappellerons les plus utiles en robotique dans ce qui suit.

Produit interne

L’addition et la multiplication à l’aide d’opérations scalaires avec des vecteurs sont tout simplement réparties sur les composants. Sinon, les deux opérations les plus pertinentes en robotique sont les produits scalaires et vectoriels dot productscalar productcross product. Le produit interne est également connu sous le nom de produit scalaire, car le résultat du produit interne de deux vecteurs arbitraires est un scalaire. Laisser [latex]\overrightarrow{a}[/latex]et [latex]\overrightarrow{b}[/latex] être deux vecteurs arbitraires et leur amplitude correspondante [5] être [latex]\| \overrightarrow{a} \|[/latex] et [latex]\| \overrightarrow{b} \|[/latex], alors le produit interne de ces deux vecteurs est

| [latex]\begin{equation}\overrightarrow{a}\cdot\overrightarrow{b}=\| \overrightarrow{a} \| \| \overrightarrow{b} \| \cos\theta\end{equation}[/latex] | (6.3) |

où θ représente l’angle entre ces deux vecteurs. Si les deux vecteurs sont orthogonaux, par définition, le résultat sera nul. Si des composants sont utilisés, alors nous avons

| [latex]\begin{equation}\mathbf{a}\cdot\mathbf{b}=a_1b_1+a_2b_2+a_3b_3+\dots+a_{n-1}b_{n-1}+a_nb_n\end{equation}[/latex] | (6.4) |

import numpy as np # Importation des bibliotheques

# produit interne

np.dot(a,b) # produit interne de deux entrees de type tableau

np.linalg.multi dot(a,b,c) # produit interne de deux tableaux ou plus en un seul appel

# magnitude un vecteur

np.linalg.norm(a)

En utilisant les valeurs numériques précédemment données dans (6.2), le produit interne de [latex]\overrightarrow{a}[/latex]et [latex]\overrightarrow{b}[/latex] est :

| [latex]\begin{align}\overrightarrow{a}\cdot\overrightarrow{b}=1.4142\cdot3.1623 \cos(0.4636)=&4 \end{align}[/latex] | (6.5) |

| [latex]\begin{align}\mathbf{a}^{\cal S}\cdot\mathbf{b}^{\cal S}=1\cdot1+1\cdot3=&4 \end{align}[/latex] | (6.6) |

| [latex]\begin{align}\mathbf{a}^{\cal T}\cdot\mathbf{b}^{\cal T}=0\cdot1.4142+1.4142\cdot2.8284=&4 \end{align}[/latex] | (6.7) |

Comme vous pouvez le voir sur cet exemple, les définitions géométriques et algébriques du produit interne sont équivalentes.

Produit vectoriel

L’autre type de multiplication avec des vecteurs est le produit vectoriel.

Contrairement au produit interne, le produit vectoriel de deux vecteurs donne un autre vecteur, pas un scalaire. Encore une fois, les deux vecteurs doivent avoir la même dimension.

Avec [latex]\overrightarrow{a}[/latex] et [latex]\overrightarrow{b}[/latex] utilisés ci-dessus, le produit vectoriel est défini comme

| [latex]\begin{equation} \overrightarrow{a}\times\overrightarrow{b}=\| \overrightarrow{a} \| \| \overrightarrow{b} \| \sin\theta\overrightarrow{e} \end{equation}[/latex] | (6.8) |

où, comme pour le produit interne, θ représente l’angle entre [latex]\overrightarrow{a}[/latex]et [latex]\overrightarrow{b}[/latex] , et [latex]\overrightarrow{e}[/latex] représente un vecteur unitaire [6] orthogonal aux deux premiers . Sa direction est établie avec la règle de la main droite. Dans l’espace 3D, les composants du vecteur résultant peuvent être calculés avec la formule suivante :

| [latex]\begin{equation} \mathbf{a}\times\mathbf{b}=\begin{bmatrix} a_2b_3-a_3b_2\\ a_3b_1-a_1b_3\\ a_1b_2-a_2b_1 \end{bmatrix} \end{equation}[/latex] | (6.9) |

où [latex]\mathbf{a}=[a_1\quad a_2\quad a_3]^T[/latex] et [latex]\mathbf{b}=[b_1\quad b_2\quad b_3]^T[/latex]

La règle de la main droite right-hand rule permet de déterminer facilement la direction d’un vecteur résultant du produit vectoriel de deux autres. Tout d’abord, vous pointez dans la direction du premier vecteur avec vos doigts restants, puis courbez-les pour pointer dans la direction du deuxième vecteur. Selon cette règle, le pouce de la main droite pointera dans la direction du vecteur résultant, qui est normal au plan formé par les deux vecteurs initiaux.

import numpy as np # Importation des bibliotheques

# produit vectoriel

np.cross(a,b)

Encore une fois, en utilisant les valeurs numériques utilisées ci-dessus dans (6.2), nous pouvons calculer le produit vectoriel. Bien entendu, puisque ces deux vecteurs sont plans et que le produit vectoriel est défini sur l’espace 3D, la troisième composante de Z est supposée être égale à zéro. Voici le résultat :

| [latex]\begin{align} \overrightarrow{a}\times\overrightarrow{b}=1.4142\cdot3.1623 \sin(0.4636)\overrightarrow{k}=&2\overrightarrow{k}\end{align}[/latex] | (6.10) |

| [latex]\mathbf{a}^{\cal S}\times\mathbf{b}^{\cal S}=\begin{bmatrix} 1\cdot0-0\cdot3\\ 0\cdot1-1\cdot0\\ 1\cdot3-1\cdot1 \end{bmatrix} \begin{bmatrix} 0\\ 0\\ 2 \end{bmatrix}[/latex] | (6.11) |

| [latex]\begin{align}\mathbf{a}^{\cal T}\times\mathbf{b}^{\cal T}=\begin{bmatrix} 1.4142\cdot0-0\cdot2.8284\\ 0\cdot-1.41421356-1.4142\cdot0\\ 0\cdot2.8284-1.4142\cdot-1.4142 \end{bmatrix}=&\begin{bmatrix} 0\\ 0\\ 2 \end{bmatrix}\end{align}[/latex] | (6.12) |

où [latex]\overrightarrow{k}[/latex] est le vecteur unitaire parallèle à l’axe Z. Par cette définition, vous pouvez observer que le vecteur unitaire définissant l’axe Z d’un référentiel cartésien est simplement le produit vectoriel des vecteurs unitaires définissant le X et les axes Y , suivant l’ordre donné par la règle de la main droite. Ces trois vecteurs unitaires sont communément étiquetés [latex]\overrightarrow{i}[/latex] , [latex]\overrightarrow{j}[/latex] et [latex]\overrightarrow{k}[/latex], comme illustré à la Figure 6-3. Vous devez noter que le produit vectoriel du vecteur unitaire [latex]\overrightarrow{a}[/latex] avec [latex]\overrightarrow{j}[/latex] se traduit également par [latex]\overrightarrow{k}[/latex] , depuis [latex]\overrightarrow{a}[/latex] est aussi dans le plan XY . De plus, comme vous pouvez le constater avec le produit vectoriel de [latex]\overrightarrow{i}[/latex] et [latex]\overrightarrow{k}[/latex] illustré sur la même figure, un vecteur n’est pas attaché à un point particulier de l’espace. Comme mentionné précédemment, il est défini par une direction et une magnitude, ainsi l’endroit où il est représenté n’a aucun impact sur le résultat du produit vectoriel.

Multiplication matricielle

Comme pour les vecteurs, l’addition et la multiplication par un scalaire sont également réparties sur les composants des matrices. Par contre, la multiplication matricielle est un

Figure 6-3 : Vecteurs unitaires définissant un repère cartésien

peu plus compliquée. Définissons la matrice A par des vecteurs lignes et la matrice B par des vecteurs colonnes, c’est-à-dire :

| [latex]\begin{equation} \mathbf{A}=\begin{bmatrix}\mathbf{a}_1\\\mathbf{a}_2\\\mathbf{a}_3\\\vdots\\\mathbf{a}_{n-1}\\\mathbf{a}_n\end{bmatrix},\quad \mathbf{B}=\begin{bmatrix}\mathbf{b}_1&\mathbf{b}_2&\mathbf{b}_3&\dots&\mathbf{b}_{n-1}&\mathbf{b}_n\end{bmatrix} \end{equation}[/latex] | (6.13) |

Ensuite, la multiplication matricielle est définie comme :

| [latex]\begin{equation} \mathbf{A}\mathbf{B}=\begin{bmatrix} \mathbf{a}_1\cdot\mathbf{b}_1 & \mathbf{a}_1\cdot\mathbf{b}_2 & \mathbf{a}_1\cdot\mathbf{b}_3 & \dots & \mathbf{a}_1\cdot\mathbf{b}_{n-1} & \mathbf{a}_1\cdot\mathbf{b}_{n}\\ \mathbf{a}_2\cdot\mathbf{b}_1 & \mathbf{a}_2\cdot\mathbf{b}_2 & \mathbf{a}_2\cdot\mathbf{b}_3 & \dots & \mathbf{a}_2\cdot\mathbf{b}_{n-1} & \mathbf{a}_2\cdot\mathbf{b}_{n}\\ \mathbf{a}_3\cdot\mathbf{b}_1 & \mathbf{a}_3\cdot\mathbf{b}_2 & \mathbf{a}_3\cdot\mathbf{b}_3 & \dots & \mathbf{a}_3\cdot\mathbf{b}_{n-1} & \mathbf{a}_3\cdot\mathbf{b}_{n}\\ \vdots & \vdots & \vdots & \ddots & \vdots\\ \mathbf{a}_{n-1}\cdot\mathbf{b}_1 & \mathbf{a}_{n-1}\cdot\mathbf{b}_2 & \mathbf{a}_{n-1}\cdot\mathbf{b}_3 & \dots & \mathbf{a}_{n-1}\cdot\mathbf{b}_{n-1} & \mathbf{a}_{n-1}\cdot\mathbf{b}_{n}\\ \mathbf{a}_n\cdot\mathbf{b}_1 & \mathbf{a}_n\cdot\mathbf{b}_2 & \mathbf{a}_n\cdot\mathbf{b}_3 & \dots & \mathbf{a}_n\cdot\mathbf{b}_{n-1} & \mathbf{a}_n\cdot\mathbf{b}_{n}\\ \end{bmatrix} \end{equation}[/latex] | (6.14) |

Bien que ce résultat puisse sembler effrayant au premier abord, vous pouvez voir que le [latex](i,j)[/latex] composant [7] est simplement le produit interne de [latex]i^{è}[/latex] rangée de la première matrice et la [latex]j^{è}[/latex] colonne de la deuxième matrice. Le nombre de colonnes de la première matrice [latex]\mathbf{A}[/latex] doit être égal au nombre de lignes de la deuxième matrice [latex]\mathbf{B}[/latex].

import numpy as np # Importation des bibliotheques

# multiplication matricielle

np.matmul(A,B) # pour les tableaux de type entrees

A @ B # pour les entrees ndarray

Pour illustrer cette opération, définissons [latex]\mathbf{A}[/latex] et [latex]\mathbf{B}[/latex] représentant [latex](2\times2)[/latex] des matrices, c’est-à-dire :

| [latex]\begin{equation} \mathbf{A}=\begin{bmatrix} 1 & 2\\3 & 4 \end{bmatrix},\quad \mathbf{B}=\begin{bmatrix} 1 & 0\\-1 & 2 \end{bmatrix} \end{equation}[/latex] | (6.15) |

Alors, le résultat de la multiplication matricielle est :

| [latex]\begin{equation} \mathbf{A}\mathbf{B}=\begin{bmatrix} 1\cdot1-2\cdot1 & 1\cdot0+2\cdot2\\3\cdot1-4\cdot1 & 3\cdot0+4\cdot2 \end{bmatrix}= \begin{bmatrix} -1 & 4\\-1 & 8 \end{bmatrix} \end{equation}[/latex] | (6.16) |

Il est essentiel que vous compreniez que la multiplication matricielle est non commutative, ce qui signifie que l’ordre compte, comme vous pouvez le constater dans l’exemple suivant avec des matrices [latex]\mathbf{A}[/latex] et [latex]\mathbf{B}[/latex] utilisées ci-dessus :

| [latex]\begin{equation} \mathbf{A}\mathbf{B}= \begin{bmatrix} -1 & 4\\-1 & 8 \end{bmatrix},\textrm{ but}\quad \mathbf{B}\mathbf{A}= \begin{bmatrix} 1 & 2\\5 & 6 \end{bmatrix} \end{equation}[/latex] | (6.17) |

Transposition d’une matrice

Une autre opération courante sur une matrice est le calcul de sa transposée, à savoir une opération qui retourne une matrice sur sa diagonale. La matrice générée, notée [latex]\mathbf{A}^T[/latex] a les indices de ligne et de colonne commutés par rapport à [latex]\mathbf{A}[/latex]. Par exemple, avec un [latex](3\times3)[/latex] matrice [latex]\mathbf{C}[/latex], sa transposée est définie comme :

| [latex]\begin{equation} \mathbf{C}^T=\begin{bmatrix} c_{1,1} & c_{1,2} & c_{1,3}\\ c_{2,1} & c_{2,2} & c_{2,3}\\ c_{3,1} & c_{3,2} & c_{3,3} \end{bmatrix}^T =\begin{bmatrix} c_{1,1} & c_{2,1} & c_{3,1}\\ c_{1,2} & c_{2,2} & c_{3,2}\\ c_{1,3} & c_{3,2} & c_{3,3} \end{bmatrix} \end{equation}[/latex] | (6.18) |

import numpy as np # Importation des bibliotheques

# transposition de matrice

np.transpose(A) # fonction pour une entree de type tableau

A.transpose() # methode pour ndarray

A.T # attribut pour ndarray

Puisque les vecteurs (tableau de composants) sont fondamentalement des matrices [latex](1\times n)[/latex], la transposition peut être utilisée pour calculer le produit interne de deux vecteurs avec une multiplication matricielle, c’est-à-dire

| [latex]\begin{equation} \mathbf{a}\cdot\mathbf{b}=\mathbf{a}^T\mathbf{b}=a_1b_1+a_2b_2+\dots+a_nb_n \end{equation}[/latex] | (6.19) |

Déterminant et inverse d’une matrice

Enfin, il convient de faire une brève introduction à l’inverse d’une matrice, qui est une notion courante en robotique, couvrant des domaines tels que la mécanique, le contrôle et l’optimisation. Laisser [latex]\mathbf{A}[/latex] représenter une [latex](n\times n)[/latex] matrice carrée [8]; cette matrice est inversible si

| [latex]\begin{equation} \mathbf{A}\mathbf{B}=\mathbf{1},\quad \textrm{et}\quad \mathbf{B}\mathbf{A}=\mathbf{1} \end{equation}[/latex] | (6.20) |

Ensuite, la matrice [latex]\mathbf{B}[/latex] est l’inverse de [latex]\mathbf{A}[/latex], et peut donc s’écrire [latex]\mathbf{A}^{-1}[/latex]. Les composants de [latex]\mathbf{A}^{-1}[/latex] peuvent être calculés formellement avec la formule suivante :

| [latex]\begin{equation} \mathbf{A}^{-1}=\frac{1}{\textrm{det}(\mathbf{A})}\mathbf{C}^T \end{equation}[/latex] | (6.21) |

où [latex]\textrm{det}(\mathbf{A})[/latex] s’appelle le déterminant de [latex]\mathbf{A}[/latex] et [latex]\mathbf{C}[/latex] représente la matrice des cofacteurs [9] de [latex]\mathbf{A}[/latex].

Le déterminant d’une matrice, un scalaire parfois étiqueté [latex]|\mathbf{A}|[/latex], est égal à, dans le cas d’une matrice [latex](2\times2)[/latex],

| [latex]\begin{equation} \textrm{det}(\mathbf{A})= ad-bc, \quad \textrm{où}\quad \mathbf{A}=\begin{bmatrix} a & b\\c & d \end{bmatrix} \end{equation}[/latex] | (6.22) |

De même, pour une matrice [latex]3\times3[/latex], nous avons

| [latex]\begin{equation} \textrm{det}(\mathbf{A})= a(ei-fh)-b(di-fg)+c(dh-eg), \quad \textrm{où}\quad \mathbf{A}=\begin{bmatrix} a & b & c\\d & e & f\\g & h & i \end{bmatrix} \end{equation}[/latex] | (6.23) |

Le déterminant d’une matrice est critique pour le calcul de son inverse, car un déterminant de 0 correspond à une matrice singulière , qui n’a pas d’inverse. L’inverse d’une matrice [latex](2\times2)[/latex] peut être calculé formellement avec la formule suivante

| [latex]\begin{equation} \mathbf{A}^{-1}= \frac{1}{ad-bc}\begin{bmatrix} d & -b\\-c & a \end{bmatrix}, \quad \textrm{où}\quad \mathbf{A}=\begin{bmatrix} a & b\\c & d \end{bmatrix} \end{equation}[/latex] | (6.24) |

De même, pour une matrice [latex]3\times3[/latex], nous avons

| [latex]\begin{equation} \mathbf{A}^{-1}= \frac{1}{\textrm{det}(\mathbf{A})}\begin{bmatrix} (ei-fg) & -(bi-ch) & (bf-ce)\\ -(di-fg) & (ai-cg) & -(af-cd)\\ (dh-eg) & -(ah-bg) & (ae-bd) \end{bmatrix}, \quad \textrm{où}\quad \mathbf{A}=\begin{bmatrix} a & b & c\\d & e & f\\g & h & i \end{bmatrix}\label{e:inv3D} \end{equation}[/latex] | (6.25) |

import numpy as np # Importation des bibliotheques

# determinant de la matrice

np.linalg.det(A)

# matrice inverse

np.linalg.inv(A)

Comme vous pouvez le voir sur l’équation (6.25), vous ne pouvez pas inverser une matrice avec un déterminant égal à zéro, car cela entraînerait une division par zéro. L’inverse d’une matrice est un outil utile pour résoudre un système d’équations linéaires. En effet, un système de n équations avec n inconnues peut être exprimé sous forme de matrice comme

| [latex]\begin{equation} \mathbf{A}\mathbf{x}=\mathbf{b} \end{equation}[/latex] | (6.26) |

où les inconnues sont les composantes de [latex]\mathbf{x}[/latex], les constantes sont les composantes de [latex]\mathbf{b}[/latex] et les facteurs devant chaque inconnue sont les composantes de la matrice [latex]\mathbf{A}[/latex]. Par conséquent, nous pouvons trouver la solution de ce système, à savoir les valeurs des variables inconnues, comme

| [latex]\begin{equation} \mathbf{x}=\mathbf{A}^{-1}\mathbf{b} \end{equation}[/latex] | (6.27) |

Inverses généralisés

Cependant, si nous avons plus d’équations (m) que le nombre d’inconnues (n), le système est surdéterminé, et donc [latex]\mathbf{A}[/latex] n’est plus une matrice carrée. Ses dimensions sont [latex](m\times n)[/latex]. Une solution exacte à ce système d’équations ne peut généralement pas être trouvée. Dans ce cas, on utilise une inverse généralisée ; une stratégie pour trouver une solution optimale. Plusieurs inverses généralisés, ou pseudo-inverse, se trouvent dans la littérature (Ben-Israel and Greville, 2003), chacune avec un critère d’optimisation différent. Dans le contexte de ce livre, nous présentons ici uniquement un type spécifique, à savoir l’inverse généralisé de Moore-Penrose (MPGI). Dans le cas de systèmes surdéterminés, le MPGI est utilisé pour trouver une solution approximative qui minimise la norme euclidienne de l’erreur. Cette norme est définie comme

| [latex]\begin{equation} \mathbf{e}_0=\mathbf{b}-\mathbf{A}\mathbf{x}_0 \end{equation}[/latex] | (6.28) |

où [latex]\mathbf{x}_0[/latex] et [latex]\mathbf{e}_0[/latex] sont respectivement la solution approximative et l’erreur résiduelle. La solution approximative est calculée avec

| [latex]\begin{equation} \mathbf{x}_0=\mathbf{A}^L\mathbf{b},\quad \mathbf{A}^L=(\mathbf{A}^T\mathbf{A})^{-1}\mathbf{A}^T \end{equation}[/latex] | (6.29) |

où [latex]\mathbf{A}^L[/latex] est nommée l’inverse généralisé de Moore-Penrose de gauche (LMPGI), puisque [latex]\mathbf{A}^I\mathbf{A}=\mathbf{1}[/latex].En guise d’exercice, vous pouvez tenter de démontrer cette équation. Il existe un autre MPGI qui peut être utile en robotique, mais pas aussi commun que le LMPGI, le inverse généralisé de Moore-Penrose de droite (RMPGI). L’inverse généralisé de droite est défini comme

| [latex]\begin{equation} \mathbf{A}^R \equiv \mathbf{A}^T(\mathbf{A}\mathbf{A}^T)^{-1},\quad \mathbf{A} \mathbf{A}^R = \mathbf{1}\label{e:RMPGI} \end{equation}[/latex] | (6.30) |

où [latex]\mathbf{A}[/latex] est un une matrice [latex]m\times n[/latex] avec [latex]m < n[/latex], c’est-à-dire représentant un système d’équations linéaires avec plus d’inconnues que d’équations. Dans ce cas, ce système admet une infinité de solutions. Par conséquent, notre objectif n’est pas de trouver la meilleure solution approximative, mais plutôt une solution avec une norme minimale (euclidienne). Par exemple, en robotique, lorsqu’il existe un ensemble infini de configurations articulaires possibles pour atteindre une position arbitraire avec précision à l’aide d’un manipulateur, le MPGI à droite peut nous donner la configuration en minimisant les rotations articulaires. Avec les deux inverses généralisés présentés ici, nous supposons que [latex]\mathbf{A}[/latex] représente une matrice de plein rangmatrix!rank, ce qui signifie que ses colonnes individuelles sont indépendantes si [latex]m > n[/latex], ou ses lignes individuelles sont indépendantes si [latex]m < n[/latex]. Dans le cas d’une matrice carrée [latex](m = n)[/latex], une matrice de plein rang est tout simplement non singulière.

6.4 Transformations géométriques

En robotique, il est essentiel de pouvoir décrire les relations géométriques de manière claire et sans ambiguïté. Cela est réalisé à l’aide de systèmes de coordonnées et de cadres de référence, comme mentionné précédemment. Il est possible que vous ayez déjà étudié quatre types de transformations géométriques : la translation, la mise à l’échelle, la symétrie (miroir) et la rotation. Nous allons les passer rapidement en revue, car elles sont toutes utiles pour la conception assistée par ordinateur. Cependant, il est important de noter que les transformations utilisées pour mapper les coordonnées d’une image dans une autre ne font appel qu’à la translation et à la rotation.

Dans un souci de clarté, nous présenterons toutes les transformations géométriques sous forme de matrices, afin de bénéficier des opérations et des propriétés puissantes qu’elles offrent, ainsi que de leur format condensé. En utilisant l’introduction vectorielle ci-dessus (Section 6.3.2), l’élément géométrique le plus simple sera utilisé pour introduire la transformation, le point :

| [latex]\begin{equation} P_{2D}(x,y)=\begin{bmatrix}x\\ y\end{bmatrix},~ P_{3D}(x,y,z)=\begin{bmatrix}x\\ y\\ z\end{bmatrix} \end{equation}[/latex] | (6.31) |

En réalité, il est possible d’appliquer des transformations aux entités ponctuelles afin de transformer n’importe quelle géométrie en 2D ou en 3D. à partir d’un ensemble de points, il est possible de définir des paires connectées, telles que des arêtes ou des lignes, et à partir d’un ensemble de lignes, on peut définir des boucles, c’est-à-dire des surfaces. Enfin, un ensemble de surfaces sélectionnées peut définir un solide.

6.4.1 Transformations de base

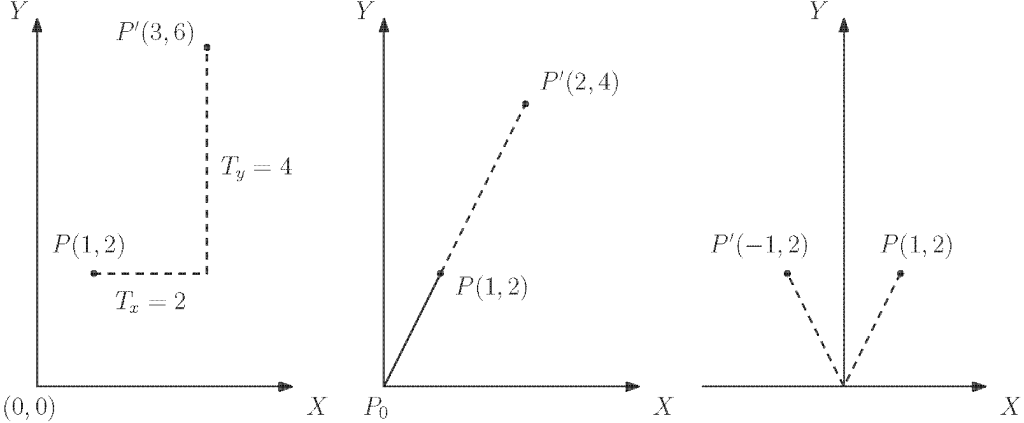

Figure 6-4 : Transformations géométriques de base, de gauche à droite : translation, mise à l’échelle et miroir (symétrie).

Commençons par un exemple numérique : étant donné un point dans [latex]x = 1[/latex] et [latex]y = 2[/latex] que nous avons l’intention de nous déplacer de 2 unités vers x positif et de 4 unités vers y positif.

La forme algébrique de cette opération est simplement [latex]x′ = x + 2[/latex]et [latex]y′ = y + 4[/latex], qui peut s’écrire sous forme matricielle :

| [latex]\begin{equation} P’=P+T=\begin{bmatrix}1\\ 2\end{bmatrix}+\begin{bmatrix}2\\ 4\end{bmatrix} \end{equation}[/latex] | (6.32) |

Un raisonnement similaire s’applique en trois dimensions. Imaginons maintenant que nous utilisons le point [latex]P[/latex] pour définir une ligne avec l’origine [latex]P_0=\begin{bmatrix}0\\ 0\end{bmatrix}[/latex]et que nous voulons étirer cette ligne avec un facteur d’échelle de 2. La forme algébrique de cette opération est simplement

| [latex]\begin{equation} P’=SP=\begin{bmatrix}2 & 0\\ 0 & 2\end{bmatrix}\begin{bmatrix}1\\ 2\end{bmatrix} \end{equation}[/latex] | (6.33) |

Cette opération de mise à l’échelle est appelée proportionnelle, puisque les deux axes ont le même facteur d’échelle. L’utilisation de différents facteurs d’échelle peut entraîner une déformation de la géométrie. Cependant, au lieu de simplement appliquer une mise à l’échelle à la géométrie, il est possible d’utiliser une matrice diagonale similaire pour changer le signe d’un ou plusieurs de ses composants. Cela aura pour effet de générer une symétrie. Par exemple, une symétrie par rapport à y est écrit:

| [latex]\begin{equation} P’=SP=\begin{bmatrix}-1 & 0\\ 0 & 1\end{bmatrix}\begin{bmatrix}1\\ 2\end{bmatrix} \end{equation}[/latex] | (6.34) |

Ces opérations sont simples et ne changent pas avec l’augmentation des dimensions de deux à trois. Les rotations, cependant, ne sont pas en tant que telles.

6.4.2 Rotations 2D/3D

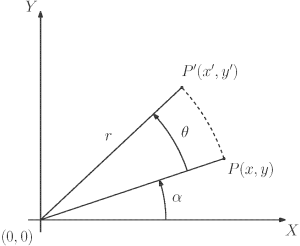

Une rotation est une transformation géométrique qui s’introduit plus facilement avec des coordonnées polaires (voir la Figure 6-5):

| [latex]\begin{equation} P=\begin{bmatrix}x\\ y\end{bmatrix}=\begin{bmatrix}r\cos(\alpha)\\ r\sin(\alpha)\end{bmatrix} \end{equation}[/latex] | (6.35) |

Figure 6-5 : Rotation planaire et coordonnées polaires.

Puis une rotation θ appliqué à ce vecteur consiste à :

| [latex]\begin{equation} P’=\begin{pmatrix}r\cos(\alpha+\theta)\\ r\sin(\alpha+\theta)\end{pmatrix}, \end{equation}[/latex] | (6.36) |

qui peut être divisé par rapport aux angles en utilisant des identités trigonométriques communes conduisant à P′ =

| [latex]\begin{equation} P’=\begin{bmatrix}x\cos(\theta)-y\sin(\theta)\\ x\sin(\theta)+y\cos(\theta)\end{bmatrix}=\begin{bmatrix}\cos(\theta) & -\sin(\theta)\\ \sin(\theta) & \cos(\theta)\end{bmatrix}\begin{bmatrix}x\\ y\end{bmatrix} \label{e:2drot} \end{equation}[/latex] | (6.37) |

La matrice résultante [latex]2\times2[/latex] est appelée matrice de rotation et son format est unique en 2D.

Toute rotation dans le plan peut être représentée par cette matrice, en utilisant la règle de droite pour le signe de θ. Cette matrice est unique, car il existe un seul axe de rotation pour la géométrie plane : la perpendiculaire au plan (souvent définie comme z − axis). En ce qui concerne la géométrie dans l’espace tridimensionnel, il existe une infinité d’axes de rotation potentiels. Il suffit de visualiser les mouvements de rotation que l’on peut appliquer à un objet tenu dans la main. Une approche pour relever ce défi consiste à définir un vecteur directeur dans l’espace et un angle de rotation autour de celui-ci, puisque Leonhard Euler nous a appris que « dans l’espace tridimensionnel, tout déplacement d’un corps rigide tel qu’un point sur le corps rigide reste fixe, équivaut à une rotation unique autour d’un axe passant par le point fixe ». Bien que cette représentation soit intéressante pour les amateurs de géométrie, elle n’est pas pratique à implémenter dans des programmes informatiques pour des rotations généralisées. Au lieu de cela, nous pouvons décomposer toute rotation tridimensionnelle en une séquence de trois rotations autour des axes principaux. Cette approche est appelée Euler’s Angles et est la représentation la plus courante de la rotation tridimensionnelle. Il suffit de définir trois matrices :

| [latex]\mathbf{R}_x=\begin{bmatrix}1 & 0 & 0\\ 0 & \cos(\psi) & -\sin(\psi)\\ 0 & \sin(\psi) & \cos(\psi)\end{bmatrix},[/latex] | (6.38) |

| [latex]\mathbf{R}_y=\begin{bmatrix}\cos(\phi) & 0 & \sin(\phi)\\ 0 & 1 & 0\\-\sin(\phi) & 0 & \cos(\phi)\end{bmatrix},[/latex] | (6.39) |

| [latex]\mathbf{R}_z=\begin{bmatrix}\cos(\theta) & -\sin(\theta) & 0\\ \sin(\theta) & \cos(\theta) & 0\\ 0 & 0 & 1\end{bmatrix}[/latex] | (6.40) |

Bien que ces matrices soient suffisantes pour représenter toutes les rotations, elles laissent néanmoins deux définitions arbitraires en suspens :

- l’orientation des axes principaux [latex](x − y − z)[/latex] dans l’espace,

- l’ordre des rotations.

Les matrices de rotation sont des opérations de multiplication sur des caractéristiques géométriques, et comme cela a été mentionné précédemment, ces opérations ne sont pas commutatives. La solution consiste à s’entendre sur un ensemble universel de conventions :

| [latex]\begin{equation} XYX,~XYZ,~XZX,~XZY,~YXY,~YXZ,~YZX,~YZY,~ZXY,~ZXZ,~ZYX,~et~ZYZ \end{equation}[/latex] | (6.41) |

Ces douze conventions nécessitent encore la définition de l’orientation de leurs axes : chaque axe peut soit être fixé au repère inertiel (souvent appelé rotations extrinsèques) ou attaché au corps en rotation (souvent appelé rotations intrinsèques. Par exemple, la matrice de rotation fixe pour la convention XYZ est :

| [latex]\begin{equation} \mathbf{R}_z\mathbf{R}_y\mathbf{R}_x=\begin{bmatrix}\cos_{\theta}\cos_{\phi} & \cos_{\theta}\sin_{\phi}\sin_{\psi}-\sin_{\theta}\cos_{\psi} & \cos_{\theta}\sin_{\phi}\cos_{\psi}+\sin_{\theta}\sin_{\psi}\\ \sin_{\theta}\cos_{\phi} & \sin_{\theta}\sin_{\phi}\sin_{\psi}-\cos_{\theta}\cos_{\psi} & \sin_{\theta}\sin_{\phi}\cos_{\psi}-\cos_{\theta}\sin_{\psi}\\ -\sin_{\phi} & \cos_{\phi}\sin_{\psi} & \cos_{\phi}\cos_{\psi}\end{bmatrix} \end{equation}[/latex] | (6.42) |

Bien que l’utilisation d’un cadre de référence fixe puisse sembler plus facile à visualiser, la plupart des contrôleurs intégrés exigent que les mouvements de rotation soient exprimés dans le cadre du corps lui-même attaché à l’objet et se déplace avec lui. La même convention XY Z, mais dans le cadre mobile est :

| [latex]\begin{equation} \mathbf{R}_x'\mathbf{R}_y'\mathbf{R}_z'=\begin{bmatrix} \cos_{\phi}\cos_{\theta} & -\cos{\phi}\sin_{\theta} & \sin_{\phi}\\ \cos_{\psi}\sin_{\theta}+\sin_{\psi}\sin_{\phi}\cos_{\theta} & \cos_{\psi}\cos_{\theta}-\sin_{\psi}\sin_{\phi}\sin_{\theta} & -\sin_{\psi}\cos_{\phi}\\ \sin_{\psi}\sin_{\theta}-\cos_{\psi}\sin_{\phi}\cos_{\theta} & \sin_{\psi}\cos_{\theta}+\cos_{\psi}\sin_{\phi}\sin_{\theta} & \cos_{\psi}\cos_{\phi}\end{bmatrix} \end{equation}[/latex] | (6.43) |

En aviation, la convention la plus courante est le ZYX (roulis-tangage-lacet) aussi appelé la variante Tait-Bryan. En robotique, chaque fabricant et développeur de logiciels décide de la convention qu’il préfère utiliser. Par exemple, FANUC et KUKA utilisent la convention d’angle d’Euler XYZ fixe, tandis qu’ABB utilise la convention d’angle d’Euler mobile ZYX.

Pour ce qui est de la conception assistée par ordinateur, les angles d’Euler utilisés dans CATIA et SolidWorks sont décrits selon la convention des angles d’Euler mobiles ZYZ.

Il est important de noter qu’une limitation majeure de la représentation des angles d’Euler est le phénomène connu sous le nom de verrouillage du cardan.gimbal lock. En un coup d’oeil, chaque convention présente des orientations singulières, ce qui signifie qu’il existe des configurations où deux axes se superposent, ayant ainsi le même effet sur la rotation. Lorsque deux axes génèrent la même rotation, il y a des zones de l’espace tridimensionnel qui ne sont plus accessibles, c’est-à-dire qu’une rotation devient impossible. Le verrouillage du cardan est devenu un problème assez répandu dans le contrôle des engins spatiaux depuis qu’il a été observé lors de la mission Apollo (Jones and Fjeld, 2006). Néanmoins, les angles d’Euler demeurent la représentation la plus courante et la plus intuitive pour la rotation et l’orientation tridimensionnelles. Cependant, en raison de la limitation du verrouillage du cardan, d’autres représentations, souvent plus complexes, ont été introduites pour y remédier.

6.4.3 Quaternion

L’une de ces représentations sans verrouillage de cardan est le quaternion. Le quaternion est un concept mathématique assez complexe par rapport au niveau requis pour ce manuel.

Nous n’essayerons pas de définir précisément le quaternion en fonction de sa construction mathématique ni de détailler toutes ses propriétés et opérations. Cependant, vous pouvez appréhender le concept en le comparant aux nombres imaginaires, un concept mathématique plus courant.

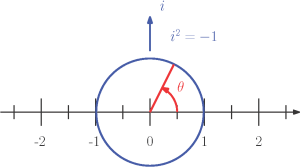

Figure 6-6 : Représentation vectorielle de la rotation plane à l’aide de l’axe imaginaire i.

On rappelle que l’axe imaginaire [latex](i)[/latex] est orthogonal aux nombres réels un (voir la Figure 6-6), avec la propriété unique [latex]i^2=-1[/latex]. Ensemble, ils créent un cadre de référence plan qui peut être utilisé pour exprimer des rotations :

| [latex]\begin{equation} R(\theta)=\cos(\theta)+\sin(\theta)i \label{e:im} \end{equation}[/latex] | (6.44) |

En d’autres termes, nous pouvons représenter une rotation dans le plan sous la forme d’un vecteur avec une partie imaginaire. Maintenant, imaginez que nous ajoutions deux rotations supplémentaires, comme défini précédemment avec les angles d’Euler. Pour représenter ces rotations, nous aurons besoin de deux autres axes orthogonaux « imaginaires ». L’équation (6.44) devient :

| [latex]\begin{equation} R(\theta)=\cos(\theta)+\sin(\theta)(\text{x}i+\text{y}j+\text{z}k) \end{equation}[/latex] | (6.45) |

Bien que cela puisse être facilement confondu avec une représentation d’angle vectoriel, il faut se rappeler que [latex]i−j −k[/latex] définit des axes « imaginaires »; et non pas des coordonnées dans l’espace cartésien. Ces axes ont des propriétés similaires à celles des axes plus courants [latex]i[/latex] axe imaginaire :

| [latex]\begin{equation} \left\| i,j,k\right\|=1,~ji=-k,~ij=k,~i^2=-1 \end{equation}[/latex] | (6.46) |

Pour la plupart des gens, il peut être difficile de visualiser les quaternions par rapport aux angles d’Euler. Cependant, les quaternions offrent une représentation sans singularité et présentent plusieurs avantages du point de vue informatique. C’est pourquoi les développeurs de ROS (voir chapitre 5) ont choisi les quaternions comme représentation standard. En Python la bibliothèque scipy contient un ensemble de fonctions permettant de passer facilement d’une représentation à une autre :

# Importer la bibliotheque

from scipy.spatial.transform import Rotation as R

# Creer une rotation avec des angles Euler

mat = R.from euler(’yxz’, [45, 0, 30], degrees=True)

print("Euler: ", mat.as euler(’yxz’, degrees=True))

# Imprimer le quaternion resultant

print("Quaternion: ", mat.as quat ())

6.4.4 Matrices de transformation homogènes

Une méthode normalisée pour appliquer une transformation d’un système de coordonnées à un autre, c’est-à-dire pour mapper un vecteur d’un référentiel à un autre, consiste à utiliser des matrices de transformation homogènes. En effet, une matrice de transformation homogène peut être utilisée pour décrire à la fois la position et l’orientation d’un objet. La [latex](4\times4)[/latex] matrice de transformation homogène est définie comme

| [latex]\begin{equation} \mathbf{H}_{\cal S}^{\cal T} \equiv \begin{bmatrix} \mathbf{Q} & \mathbf{p}\\ \mathbf{0}^T & 1 \end{bmatrix} \label{e:DH_transformation} \end{equation}[/latex] | (6.47) |

où Q est la [latex](3\times3)[/latex] matrice de rotation (orientation), [latex]\mathbf{p}[/latex] est le vecteur tridimensionnel définissant la position cartésienne[latex][x,\quad y,\quad z][/latex] de l’origine et [latex]\mathbf{0}[/latex] est le vecteur nul tridimensionnel. Comme on peut le constater avec l’exposant et l’indice de [latex]\mathbf{H}[/latex], la matrice définit le référentiel [latex]\cal T[/latex] dans le cadre du référentiel [latex]\cal S[/latex]. Effectivement, bien que les matrices de transformation homogènes soient composées de 9 composantes, elles ne sont pas toutes indépendantes, car la position et l’orientation dans l’espace cartésien totalisent 6 degrés de liberté (DoF). La matrice homogène combine la translation mentionnée précédemment avec la rotation, ce qui permet d’utiliser uniquement des multiplications pour effectuer la transformation, au lieu d’ajouter séparément la translation et la rotation.

6.5 Probabilité de base

6.5.1 Probabilité

Lorsque nous parlons de probabilité, nous sommes généralement intéressés par la prédiction de la probabilité qu’un événement se produise, exprimée en [latex]P(event)[/latex]. Au niveau le plus élémentaire, cela peut être conceptualisé comme une proportion représentant le nombre d’événements qui nous intéressent (qui satisfont certains critères spécifiques) divisé par le nombre total d’événements possibles, qui ont tous une probabilité égale.

Vous trouverez ci-dessous un résumé de la notation utilisée pour décrire les différents types et combinaisons d’événements de probabilité qui seront utilisés dans la suite de cette section.

| P(A) | Probabilité que A se produise |

| P(A′) | Probabilité que A ne se produise pas |

| P(A ∩ B) | Probabilité que A et B se produisent à la fois |

| P(A ∪ B) | Probabilité que A ou B se produise |

| P(A|B) | Probabilité que A se produise étant donné que B se produit |

Tableau 6-1 : Notations de probabilité courantes

Par exemple, supposons que nous ayons un dé à 6 faces typique (non truqué). Chacune des six faces a une probabilité égale de se produire à chaque lancer du dé. Par conséquent, le nombre total de résultats possibles lors d’un seul lancer de dé, chacun ayant une probabilité égale de se produire, est de 6. Ainsi, nous pouvons représenter la probabilité d’obtenir un nombre spécifique lors d’un lancer de dé comme une proportion sur 6.

Par exemple, la probabilité d’obtenir un 3 peut être exprimée par :

| [latex]\begin{equation} P(3) = \frac{1}{6} \end{equation}[/latex] | (6.48) |

La probabilité d’un événement qui ne se produit pas est toujours l’inverse de la probabilité qu’il se produise, ou [latex]1 - P(\textrm{event})[/latex]. Ceci est connu sous le nom de règle de soustraction.

| [latex]\begin{equation} P(A) = 1 - P(A') \end{equation}[/latex] | (6.49) |

Ainsi, dans l’exemple ci-dessus, la probabilité de ne pas obtenir un 3 est :

| [latex]\begin{equation} P(3') = 1 - \frac{1}{6} = \frac{5}{6} \end{equation}[/latex] | (6.50) |

On pourrait aussi modifier nos critères pour être plus généraux, par exemple en calculant la probabilité d’obtenir un nombre pair lors d’un lancer de dé. Dans ce cas, nous avons maintenant 3 résultats possibles qui satisfont nos critères (obtenir un 2, un 4 ou un 6), mais le nombre total d’événements possibles reste à 6. Ainsi, la probabilité d’obtenir un nombre pair est :

| [latex]\begin{equation} P(\textrm{even}) = \frac{3}{6} = \frac{1}{2} \end{equation}[/latex] | (6.51) |

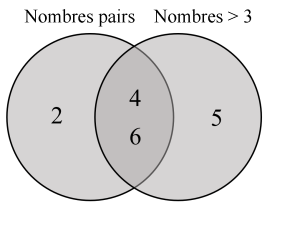

Maintenant, imaginons que nous élargissions ces critères pour calculer la probabilité d’obtenir soit un nombre pair, soit un nombre supérieur à 3 lors d’un lancer de dé. Nous avons maintenant deux critères distincts qui nous intéressent (être un nombre pair ou être supérieur à 3), et nous voulons calculer la probabilité qu’un seul lancer de dé donne l’un ou l’autre de ces résultats.

Pour commencer, nous pourrions simplement essayer d’additionner la probabilité de chaque résultat individuel :

| [latex]\begin{equation} \begin{split} P(\textrm{even } \cup > 3) &= \frac{3}{6} + \frac{3}{6} = \frac{6}{6} = 1 \end{split} \end{equation}[/latex] | (6.52) |

En effet, nous nous sommes retrouvés avec une probabilité de 1, ce qui signifie une certitude de 100. L’erreur de calcul provient du fait qu’il existe des nombres qui sont à la fois pairs ET supérieurs à 3 (à savoir, 4 et 6). En additionnant simplement les probabilités, nous avons « compté deux fois » leur probabilité de se produire, ce qui a faussé le résultat. Dans la Figure 6-7, nous pouvons constater que si nous créons un diagramme de Venn avec des nombres pairs et des nombres > 3, ils se chevauchent au milieu avec les valeurs de 4 et 6. Si nous considérons la probabilité comme le calcul de la surface totale de ces cercles dans un diagramme de Venn, nous n’avons besoin de compter qu’une seule fois le chevauchement des événements.

Figure 6-7 : Diagramme de Venn des nombres pairs et des nombres supérieurs à 3

Donc, pour surmonter le double comptage, nous devons soustraire la probabilité que les deux événements se produisent simultanément (dans cet exemple, la probabilité d’obtenir un nombre qui est à la fois pair ET supérieur à 3) de la probabilité totale obtenue en additionnant les probabilités des événements individuels.

| [latex]\begin{equation} P(\textrm{even } \cup > 3) = \frac{3}{6} + \frac{3}{6} - \frac{2}{6} = \frac{4}{6} = \frac{2}{3} \end{equation}[/latex] | (6.53) |

Plus généralement, on parle de règle d’addition, qui prend la forme générale :

| [latex]\begin{equation} P(A \cup B) = P(A) + P(B) - P(A \cap B) \end{equation}[/latex] | (6.54) |

Dans le cas où deux résultats ne peuvent pas se produire simultanément (c’est-à-dire qu’il n’y a pas de chevauchement dans le diagramme de Venn), alors [latex]P(A \cup B) = P(A) + P(B)[/latex], comme [latex]P(A \cap B) = 0[/latex]. Ceci est connu comme des événements mutuellement exclusifs.

Enfin, supposons que nous modifions légèrement nos critères pour nous intéresser à la probabilité d’obtenir à la fois un nombre pair ET un nombre supérieur à 3 lors d’un lancer de dé. Vous avez peut-être remarqué que nous avons déjà utilisé la probabilité que les événements « nombre pair » et « nombre supérieur à 3 » se produisent simultanément dans l’équation précédente pour calculer la probabilité que l’un des deux événements se produise, [latex]P(\textrm{even } \cap > 3) = \frac{2}{6} = \frac{1}{3}[/latex]. Effectivement, dans cet exemple avec un petit nombre de résultats possibles, il est relativement simple de compter directement le nombre de résultats qui satisfont nos critères. Cependant, dans des scénarios plus complexes, le calcul de probabilité peut devenir plus difficile.

Donc, pour commencer à réfléchir à la question de savoir comment calculer la probabilité que deux événements se produisant simultanément, nous pouvons d’abord demander quelle est la probabilité que l’un des événements se produise, étant donné que l’autre événement s’est déjà produit. Dans cet exemple, nous pourrions calculer la probabilité d’obtenir un nombre supérieur à 3, étant donné que le nombre obtenu est déjà pair. Autrement dit, si nous avons déjà lancé le dé et savons que le résultat est un nombre pair, quelle est la probabilité qu’il soit aussi supérieur à 3?

Nous savons déjà qu’il y a trois faces du dé qui ont des nombres pairs (2, 4 ou 6). Cela signifie que notre nombre de résultats possibles, si nous savons que le résultat est pair, est réduit de 6 à 3. On peut alors compter le nombre de résultats de cet ensemble qui sont supérieurs à 3. Cela nous donne deux résultats (4 et 6). Ainsi, la probabilité de lancer un nombre supérieur à 3, étant donné qu’il est aussi pair est :

| [latex]\begin{equation} P(>3 | \textrm{even}) = \frac{2}{3} \end{equation}[/latex] | (6.55) |

Cependant, ce calcul surestime encore la probabilité que les deux événements se produisent simultanément, car nous avons réduit notre scénario à celui où nous sommes déjà certains à 100% qu’un des résultats s’est produit (nous avons déjà supposé que le résultat du lancer est un nombre pair). Donc, pour remédier à cela, nous pouvons alors multiplier cette équation par la probabilité globale d’obtenir un nombre pair lors du lancer, que nous avons déjà mentionnée précédemment comme étant[latex]P = \frac{3}{6}[/latex].

| [latex]\begin{equation} P(\textrm{even } \cap >3) = \frac{3}{6} \times \frac{2}{3} = \frac{6}{18} = \frac{1}{3} \end{equation}[/latex] | (6.56) |

Cela nous donne la même valeur, [latex]P(A \cap B) = \frac{1}{3}[/latex] que nous avons vu dans notre équation précédente. Ceci est également appelé la règle de multiplication, avec la forme générale :

| [latex]\begin{equation} P(A \cap B) = P(A)P(B|A) \end{equation}[/latex] | (6.57) |

Un autre aspect à prendre en compte lors du calcul de la probabilité est de déterminer si les événements sont dépendants ou indépendants. Dans l’exemple des dés, ces événements sont dépendants, car le fait qu’un événement se produise (obtenir un nombre pair) affecte la probabilité de l’autre événement (obtenir un nombre supérieur à 3). La probabilité globale d’obtenir un nombre supérieur à 3 est [latex]\frac{1}{2}[/latex] , mais augmente à [latex]\frac{2}{3}[/latex] si nous savons déjà que le nombre obtenu est pair.

Si les événements sont indépendants, ce qui signifie qu’ils n’affectent pas la probabilité de se produire mutuellement, la règle de multiplication se simplifie à :

| [latex]\begin{equation} P(A \cap B) = P(A) \times P(B) \end{equation}[/latex] | (6.58) |

La règle de multiplication constitue également la base du théorème de Bayes, qui sera abordé dans la section suivante.

6.5.2 Théorème de Bayes

Le théorème de Bayes est un principe important utilisé en intelligence artificielle pour calculer la probabilité des prochaines étapes d’un robot en tenant compte des étapes qu’il a déjà exécutées. Le théorème de Bayes est défini par :

| [latex]\begin{equation} P(A \cap B) = \frac{P(A)P(B|A)}{P(B)} \end{equation}[/latex] | (6.59) |

Les robots, et parfois les humains, sont dotés de capteurs bruyants et ont une connaissance limitée de leur environnement. Imaginons un robot mobile utilisant la vision pour détecter des objets et sa propre position. Lorsqu’il détecte un four, il peut utiliser cette information pour déduire sa propre position. Ce que nous savons, c’est que la probabilité de voir un four dans une salle de bain est assez faible, tandis qu’elle est élevée dans une cuisine. C’est là que le théorème de Bayes entre en jeu. Vous n’êtes pas certain à 100% de cela, car il est possible que vous l’ayez récemment acheté et l’ayez laissé dans le salon, ou que vos capacités visuelles soient altérées (vos capteurs de vision sont bruyants et peu fiables). Dans ce contexte, il est raisonnable de supposer que, étant donné que vous avez vu un four, il est « plus probable » que vous soyez dans une cuisine plutôt que dans une salle de bain. Le théorème de Bayes offre un mécanisme (mais pas le seul) pour effectuer ce type de raisonnement.

[latex]P(room)[/latex] est la croyance « antérieure » avant que vous n’avez vu le four, [latex]P(oven|room)[/latex] fournit la probabilité de voir un four dans une pièce, et [latex]P(room|oven)[/latex] est votre nouvelle croyance après avoir vu le four. Ceci est également appelé la probabilité « postérieure », la probabilité conditionnelle qui résulte après avoir examiné les preuves disponibles (dans ce cas, une observation du four).

6.5.3 Distribution gaussienne

En effet, dans la réalité, les événements n’ont pas toujours la même probabilité de se produire.

Lorsque différents résultats ont des probabilités différentes de se produire, nous pouvons envisager ces probabilités en termes de fréquences. Plus précisément, nous pouvons nous demander, sur un certain nombre de répétitions d’un événement, à quelle fréquence un résultat spécifique est susceptible de se produire? Nous pouvons tracer ces fréquences sur un histogramme de fréquence, qui compte le nombre de fois que chaque événement s’est produit. Cette logique constitue la base des statistiques fréquentistes, dont nous discuterons plus en détail dans la Section 6.7.

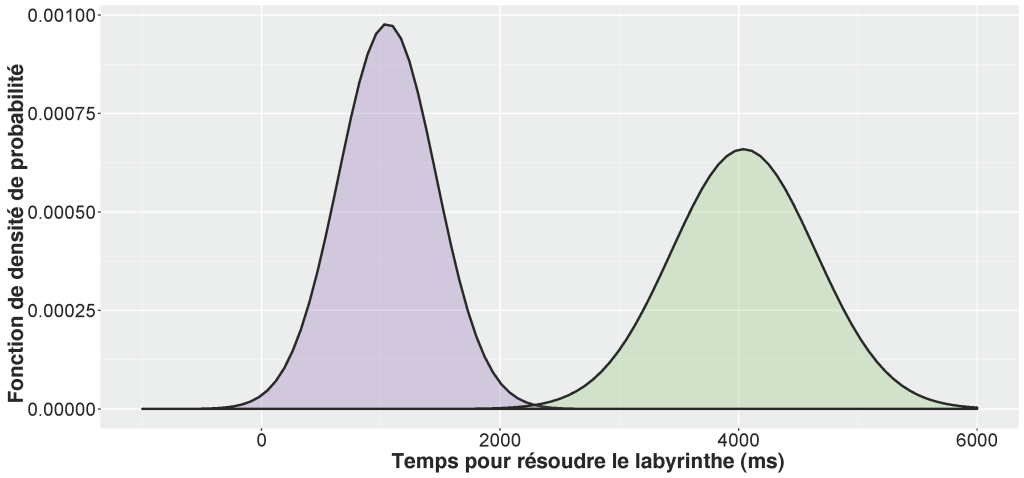

La distribution gaussienne, également connue sous le nom de distribution normale ou « courbe en cloche », désigne une distribution de fréquence ou un histogramme de données dans lequel les points de données sont répartis de manière symétrique. Cela signifie qu’il y a un « pic » dans la distribution, représentant la moyenne, où la plupart des valeurs de l’ensemble de données se situent. Ensuite, la distribution diminue symétriquement de chaque côté à mesure que les valeurs deviennent moins fréquentes (voir la Figure 6-8). De nombreux ensembles de données d’origine naturelle suivent une distribution normale, par exemple la taille moyenne de la population, les résultats des tests à de nombreux examens et le poids des sauterelles lubber.

En robotique, on observe une distribution normale sur la sortie de plusieurs capteurs. En fait, le théorème central limit suggère qu’avec un échantillon suffisamment grand, de nombreuses variables tendront vers une distribution normale, (même si elles ne suivaient pas initialement une distribution normale). Cela en fait un point de départ utile pour de nombreuses analyses statistiques.

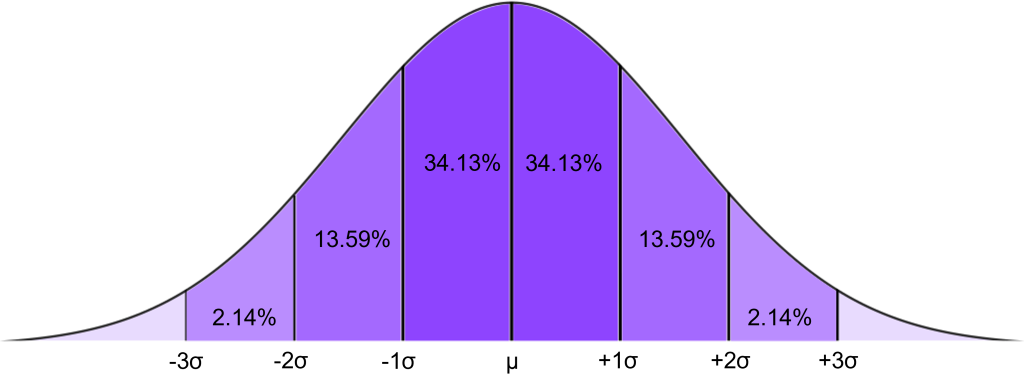

Figure 6-8 : La distribution normale

Nous pouvons utiliser la distribution normale pour prédire la probabilité qu’un point de données se situe dans une certaine zone sous la courbe. Plus précisément, si nos données suivent une distribution normale, nous savons que 68,27% des points de données se situeront à moins de 1 écart-type de la moyenne, 95,45% se situeront à moins de 2 écarts-types, et 99,73% se situent à moins de 3 écarts-types. En termes de probabilité, nous pourrions exprimer cela en disant « qu’il y a une probabilité de 68,27% qu’une valeur choisie au hasard se situe à moins d’un écart-type de la moyenne ». Plus une valeur s’éloigne de la moyenne (le sommet de la courbe), moins sa probabilité d’occurrence est élevée. La probabilité totale de toutes les valeurs de la distribution normale (c’est-à-dire l’aire totale sous la courbe) est égale à 1.

Mathématiquement, l’aire sous la courbe est représentée par une fonction de densité de probabilité, où la probabilité de tomber dans un intervalle donné est égale à l’aire sous la courbe pour cet intervalle. En d’autres termes, nous pouvons utiliser la distribution normale pour calculer la densité de probabilité de voir une valeur, [latex]x[/latex], étant donné la moyenne, [latex]\mu[/latex], et l’écart-type, [latex]\sigma^2[/latex].

| [latex]\begin{equation} p(x|\mu,\sigma^2) = \frac{1}{{\sqrt{2\pi\sigma^2}}}e^{-\frac{1}{2}\frac{(x-\mu)^2}{2\sigma^2}} \end{equation}[/latex] | (6.60) |

Nous pouvons constaté qu’il n’y a en fait que deux paramètres qui doivent être saisis, [latex]\mu[/latex] et [latex]\sigma^2[/latex]. La simplicité de cette représentation est également pertinente pour les applications en informatique et en robotique.

Dans une distribution normale standard, la moyenne est de 0 et l’écart type est de 1. La moyenne et l’écart type de n’importe quel jeu de données distribué normalement peuvent ensuite être transformés pour s’adapter à ces paramètres à l’aide de la formule suivante :

| [latex]\begin{equation} z = \frac{x - \mu}{\sigma} \end{equation}[/latex] | (6.61) |

Ces valeurs transformées sont appelées scores z. Ainsi, si nous avons la moyenne et l’écart type de tout ensemble de données normalement distribué, nous pouvons le convertir en z-scores.

Ce processus est connu sous le nom standardisation et il est utile, car il nous permet d’utiliser les propriétés mentionnées précédemment de la distribution normale pour déterminer la probabilité qu’une valeur spécifique se produise dans n’importe quel ensemble de données qui suit une distribution normale, indépendamment de sa moyenne et de son écart type réels.

C’est parce que chaque z-score est associé à une probabilité spécifique de se produire (nous connaissons déjà les probabilités pour les z-scores à exactement 1, 2 et 3 écarts-types audessus/en dessous de la moyenne). Vous pouvez tout vérifier toutes les probabilités de score z en utilisant les z-tables [10]. à partir de ces z-tables, nous pouvons calculer le pourcentage de la population qui tombe soit au-dessus ou au-dessous d’un certain z-score. Un z-score peut alors être considéré comme une statistique de test représentant la probabilité qu’un résultat spécifique se produise dans un ensemble de données (normalement distribué). Cette étape devient particulièrement importante lors de la réalisation de statistiques inférentielles, qui seront traitées plus en détail dans la suite de ce chapitre.

6.6 Dérivés

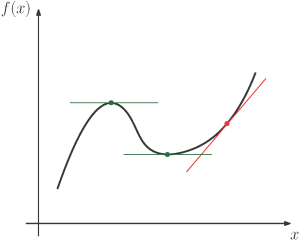

Figure 6-9 : La dérivée d’une fonction donne la pente instantanée de cette fonction. Les emplacements à dérivée nulle sont en représentés en vert : les optimums.

Le calcul différentiel joue un rôle fondamental dans de nombreux concepts mathématiques en robotique, allant de la recherche de gains optimaux à la linéarisation de systèmes dynamiques complexes. La dérivée d’une fonction [latex]f(x)[/latex]est la vitesse à laquelle sa valeur change.

Il peut être approximé par [latex]f'(x)=\frac{\Delta f(x)}{\Delta x}[/latex] . Cependant, plusieurs fonctions algébriques ont des dérivées exactes connues, comme [latex]\dfrac{dx^{n}}{dx}=nx^{n-1}[/latex]. En robotique, nous manipulons des dérivées pour des variables physiques telles que la vitesse ([latex]\dot{x}[/latex]), la dérivée de la position [latex](x)[/latex], et l’accélération ([latex]\ddot{x}[/latex]), la dérivée de la vitesse. En plus de cela, la dérivée peut être utile pour trouver une fonction optimale : lorsque la dérivée d’une fonction est égale à zéro, nous sommes soit à un minimum (local) soit à un maximum (local) (voir la Figure 6-9). Plusieurs propriétés sont utiles à retenir, comme l’opérateur de dérivée qui peut être distribué sur l’addition :

| [latex]\begin{equation} [f(x)+g(x)]'=f'(x)+g'(x), \end{equation}[/latex] | (6.62) |

et réparti sur des fonctions imbriquées :

| [latex]\begin{equation} f(g(x))'=f'(g(x))g'(x) \end{equation}[/latex] | (6.63) |

Enfin, les opérateurs dérivés peuvent être distribués sur une fonction multivariée, en utilisant des dérivées partielles, c’est-à-dire les dérivées par rapport à chaque variable indépendamment.

Par exemple :

| [latex]\dfrac{\partial \left[ Ax_{1}+Bx_{2}\right] }{\partial x_{1}}=A[/latex] | (.6.64) |

6.6.1 Série Taylor

La robotique implique la tentative de contrôler des systèmes dynamiques complexes dans des environnements dynamiques complexes. Dans la plupart des cas, ces systèmes et modèles présentent des dynamiques non linéaires. Par exemple, les forces de traînée sur les avions et les sous-marins ont un impact sur l’accélération du véhicule en fonction du carré de sa vitesse.

Une manière de faire face à cette complexité est de simplifier l’équation en utilisant une approximation polynomiale, qui consiste à additionner différentes puissances de la variable.

La plus populaire est certainement la série Taylor :

| [latex]\begin{equation} f(x)\rvert_a=f(a)+\frac{f'(a)}{1!}(x-a)+\frac{f''(a)}{2!}(x-a)^2+\frac{f'''(a)}{3!}(x-a)^3+... \end{equation}[/latex] | (6.65) |

qui approxime [latex]f(x)[/latex] autour du point [latex]x = a[/latex] en utilisant une combinaison de ses dérivés. Si nous voulons que notre approximation linéarise la fonction, nous ne garderons que les deux premiers termes :

| [latex]\begin{equation} f(x)\approx f(a)+f'(a)(x-a) \end{equation}[/latex] | (6.66) |

6.6.2 Jacobien

Maintenant, au lieu d’une seule fonction dépendant d’une seule variable, vous vous retrouverez souvent avec un ensemble d’équations dépendant chacune de plusieurs variables. Par exemple :

| [latex]\begin{equation} f_1=Axy,~f_2=Cy^2+Dz,~and~f_3=E/x+Fy+Gz \end{equation}[/latex] | (6.67) |

qui peut s’écrire sous forme de vecteur :

| [latex]\begin{equation} \mathbf{F}=\begin{bmatrix}f_1\\f_2\\f_3\end{bmatrix} \end{equation}[/latex] | (6.68) |

Vous pouvez linéariser ce système d’équations en utilisant la série de Taylor :

| [latex]\begin{equation} \mathbf{F}\approx \mathbf{F}(a)+\mathbf{J}\begin{bmatrix}x-x_a\\y-y_a\\z-z_a\end{bmatrix}, \end{equation}[/latex] | (6.69) |

où [latex]\mathbf{J}[/latex] est la matrice des dérivées partielles des fonctions, souvent appelée jacobienne, dans ce cas :

| [latex]\begin{align} \mathbf{J} = \begin{bmatrix}\dfrac{\partial f_1}{\partial x} & \dfrac{\partial f_1}{\partial y} & \dfrac{\partial f_1}{\partial z}\\ \dfrac{\partial {f_2}}{\partial x} & \dfrac{\partial {f_2}}{\partial y} & \dfrac{\partial {f_2}}{\partial z} \\ \dfrac{\partial {f_3}}{\partial x} & \dfrac{\partial {f_3}}{\partial y} & \dfrac{\partial {f_3}}{\partial z} \end{bmatrix}=\begin{bmatrix}Ay & Ax & 0\\ 0 & 2Cy & D\\ -E/x^2 & F & G\end{bmatrix} \end{align}[/latex] | (6.70) |

Dans le chapitre 10, le jacobien est utilisé comme une matrice pour établir la relation entre l’espace des tâches (vitesses des effecteurs terminaux) et l’espace articulaire (vitesses des actionneurs). Une matrice jacobienne dérivée pour une seule fonction, c’est-à-dire une matrice avec une seule ligne, est appelée un gradient; noté (pour une fonction géométrique dans l’espace cartésien) :

| [latex]\begin{equation} \mathbf{\nabla}f=\begin{bmatrix}\dfrac{\partial f}{\partial x} & \dfrac{\partial f}{\partial y} & \dfrac{\partial f}{\partial z}\end{bmatrix} \end{equation}[/latex] | (6.71) |

Le gradient est un outil utile pour trouver l’optimum d’une fonction en en voyageant dessus; une approche stochastique très utile en apprentissage automatique (voir le chapitre 15).

6.7 Statistiques de base

Lorsque vous menez des recherches en robotique, notamment des études sur les utilisateurs, il est courant de disposer de données que vous avez collectées dans le but de répondre à une question de recherche spécifique. En règle générale, ces questions de recherche s’articulent autour de la relation entre une variable indépendante et une variable dépendante. Par exemple, vous pourriez vous poser la question de savoir comment le nombre de drones (variable indépendante) dans une mission affecte la charge de travail cognitive de l’opérateur (variable dépendante). Il est essentiel de pouvoir analyser les données que vous avez collectées afin de communiquer les résultats de votre recherche. Le chapitre 13 fournira plus de détails sur la conception et la conduite d’études sur les utilisateurs. Pour l’instant, nous allons commencer à expliquer certaines des analyses que vous pouvez effectuer une fois que vous avez obtenu quelques données!

La première étape de l’analyse d’un ensemble de données consiste généralement à décrire ses propriétés d’une manière significative pour votre public (statistiques descriptives).

Cela implique de prendre les données brutes et de les transformer (par exemple, en visualisations ou en statistiques récapitulatives). La deuxième étape consiste ensuite à déterminer comment vous pouvez utiliser vos données pour répondre à une question de recherche spécifique et/ou généraliser les résultats à une population plus large (statistiques déductives). Ici, il est important de faire la distinction entre un échantillon de données collectées, et la population dont les données sont destinées à être généralisées (voir également le chapitre 13). De manière critique, les statistiques descriptives se rapportent uniquement à l’échantillon réel de données que vous avez collectées, tandis que les statistiques inférentielles tentent de faire des généralisations à l’ensemble de la population. En règle générale, les formules utilisées pour calculer les valeurs d’un échantillon font appel à des lettres grecques, tandis que les formules utilisées pour une population font appel à des lettres romaines. Vous trouverez ci-dessous un tableau avec certaines des notations les plus courantes pour les échantillons et les populations.

| Paramètre | Échantillon | Population |

| Moyenne | [latex]\overline{x}[/latex] | [latex]\mu[/latex] |

| Écart-type | [latex]s[/latex] | [latex]\sigma[/latex] |

| Variance | [latex]s^2[/latex] | [latex]\sigma^2[/latex] |

| Nombre de points de données | [latex]n[/latex] | [latex]N[/latex] |

Tableau 6-2 : Notations des paramètres communs pour les échantillons par rapport aux populations

Lorsque nous recueillons des données, nos échantillons peuvent être soit indépendants (les données proviennent de deux groupes de personnes différents), soit répétés (du même groupe).

Prenons l’exemple où nous souhaitons tester les connaissances des étudiants en robotique en ce qui concerne la géométrie de base et l’algèbre linéaire. Nous pourrions soit prendre un seul échantillon d’étudiants et tester leurs connaissances avant et après la lecture de ce chapitre – ce serait une étude au sein des groupes, car les mêmes étudiants ont été testés à chaque fois.

Alternativement, nous pourrions prendre un échantillon d’étudiants qui ont lu ce chapitre du livre et les comparer à un échantillon qui n’a pas lu ce chapitre. Il n’y a pas de chevauchement entre ces deux groupes, il s’agit donc d’une conception d’étude entre-groupes.

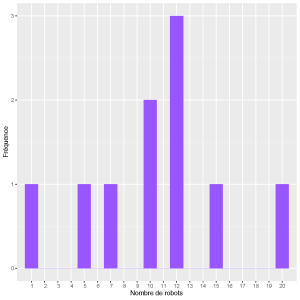

Vous pouvez d’abord commencer à décrire les propriétés de votre échantillon en utilisant trois mesures de tendance centrale; la moyenne, la médiane et le mode. Le mode représente la valeur de réponse la plus courante dans vos données . En d’autres termes, si vous prenez toutes les valeurs individuelles de votre ensemble de données et comptez combien de fois chacune apparaît, le mode correspond à la valeur qui apparaît le plus grand nombre de fois. Par exemple, imaginons que nous demandions à 10 professeurs de robotique combien de robots ils ont dans leur laboratoire (voir le Tableau 6-3).

| ID de professeur | Nombre de robots |

|

1 2 3 4 5 6 7 8 9 10 |

1 5 7 10 10 12 12 12 15 20 |

Tableau 6-3 : Exemple de données de robots par professeur

Nous pouvons voir que la valeur la plus courante signalée est 12 robots – il s’agit du mode.

Le mode peut être plus facilement identifié en créant une distribution de fréquence des valeurs dans votre ensemble de données (voir la Figure 6-10).

La médiane est la valeur qui se situe au milieu de votre plage de valeurs. En utilisant l’exemple ci-dessus, si nous avons classé le nombre de robots dans chaque laboratoire du plus petit au plus grand, la médiane est la valeur qui tombe exactement au milieu (ou, s’il y a un nombre pair de points de données, la somme des deux valeurs divisées par 2). Dans ce cas particulier, nous avons 10 valeurs, donc la médiane est la moyenne des 5e et 6e valeurs, [latex]\frac{10 + 12}{2} = 11[/latex].

Cependant, la médiane et le mode se basent tous les deux sur des valeurs uniques, ce qui signifie qu’ils ne tiennent pas compte d’une grande partie des informations disponibles dans un ensemble de données. La mesure finale de la tendance centrale est alors la moyenne, qui prend en compte toutes les valeurs des données en additionnant le total de toutes les valeurs et en les divisant par le nombre total d’observations. La formule pour calculer la moyenne d’un échantillon est exprimée comme suit :

| [latex]\begin{equation} \bar{x} = {\frac{\sum_{i=1}^Nx_i}{n}} \end{equation}[/latex] | (6.72) |

Où [latex]\bar{x}[/latex] représente la moyenne de l’échantillon, [latex]x[/latex] représente une valeur individuelle, et [latex]n[/latex] représente le nombre de valeurs dans l’ensemble de données.

Dans notre exemple, ce serait :

| [latex]\begin{equation} \bar{x}_{robots} = \frac{1 + 5 +7 + 10 + 10 + 12 + 12 + 12 + 15 + 20}{10} = 10.4 \end{equation}[/latex] | (6.73) |

Figure 6-10 : Distribution de fréquence du nombre de robots par laboratoire

Contrairement à la médiane et au mode, cette valeur ne doit pas nécessairement exister dans l’ensemble de données (par exemple, si le nombre moyen de robots dans le laboratoire est en fait de 10,4, certains étudiants ont probablement des questions à répondre…)

De nombreuses statistiques de base peuvent être calculées en utilisant Python avec la bibliothèque numpy :

import numpy as np # Importation des bibliotheques

mu = np.mean(data) # Moyenne de echantillon de donnees

mod = np.mode(data) # Mode de echantillon de donnees

med = np.median(data) # Mode de echantillon de donnees

Dans la distribution normale classique, la moyenne, la médiane et le mode sont égaux.

Cependant, dans la vie réelle, les données ne sont souvent pas parfaitement conformes à cette distribution, ainsi, ces mesures peuvent différer les unes des autres. En particulier, alors que la médiane et le mode sont relativement robustes aux valeurs extrêmes (valeurs aberrantes), la valeur de la moyenne peut changer considérablement. Par exemple, supposons que notre échantillon comprenne un professeur travaillant avec des microrobots qui déclare avoir des centaines de robots dans son laboratoire. Cela fausserait considérablement la moyenne, tout en étant peu représentatif de la majorité de l’échantillon.

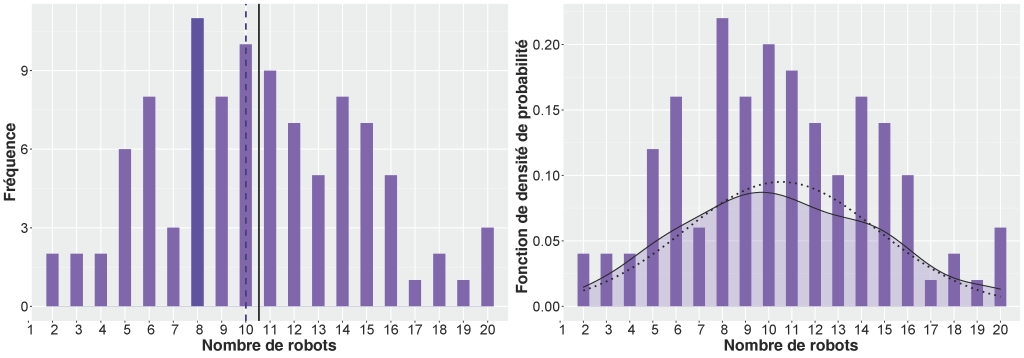

Imaginons maintenant que nous ayons demandé à 90 autres professeurs de robotique le nombre de robots dont ils disposent. Nous avons donc maintenant échantillonné un total de 100 professeurs de robotique. Nos résultats montrent maintenant la distribution de fréquence illustrée à la Figure 6-11.

Nous pouvons voir que bien que la moyenne soit toujours de 10,4, le mode est maintenant de 8 robots et la médiane de 10. Ces valeurs, bien qu’étant similaires, ne sont pas identiques, même si les données suivent une distribution normale. Nous pouvons le vérifier en utilisant la fonction de densité de probabilité. Une fois de plus, la distribution normale ne représente pas parfaitement les données, mais elle offre une très bonne approximation des données.

Figure 6-11 : Histogramme de fréquence et fonction de la densité de probabilité pour un ensemble de données distribuées normalement. Le graphique de gauche illustre les mesures de tendance centrale, où la barre violette foncée représente le mode, la ligne violette pointillée représente la médiane et la ligne noire pleine représente la moyenne. Le graphique de droite montre la distribution de probabilité réelle des données en contraste avec une distribution normale.

6.7.1 Variance

La sensibilité de nos métriques descriptives d’ensemble de données à de nouveaux points de données peut être appréhendée en termes de variabilité. Nous pouvons mesurer la quantité de variance dans un échantillon donné, ainsi que détecter les valeurs aberrantes, de plusieurs manières différentes. La première est l’écart-type. Cela représente en moyenne l’écart entre les valeurs et la moyenne. Plus l’écart type est petit, plus les valeurs de l’échantillon sont en moyenne proches de la moyenne et plus la moyenne est précise pour représenter l’échantillon.

Nous pouvons également utiliser l’écart type pour créer un seuil pour les valeurs extrêmes – toute valeur supérieure ou inférieure à 3 écarts types par rapport à la moyenne est susceptible d’être une valeur aberrante (c’est-à-dire non représentative de la population) et peut souvent être exclue.

Pour calculer l’écart type d’une variable, nous prenons d’abord chaque valeur individuelle et en soustrayons la moyenne, ce qui donne une plage de valeurs représentant les écarts par rapport à la moyenne. L’ampleur totale de ces écarts est égale à la variance totale de l’échantillon. Cependant, étant donné que certaines valeurs individuelles peuvent être supérieures à la moyenne et d’autres inférieures, nous devons mettre ces écarts au carré afin qu’ils soient tous positifs, pour éviter que les valeurs positives et négatives ne se compensent mutuellement. Nous additionnons ensuite les écarts au carré pour obtenir une valeur totale de l’erreur dans les données de l’échantillon (appelée somme des carrés). Ensuite, nous divisons par le nombre de points de données dans l’échantillon [latex](n)[/latex], moins un. Parce que nous calculons la moyenne de l’échantillon, et non la moyenne de la population, [latex]n − 1[/latex] représente le degrés de liberté dans l’échantillon. En effet, nous connaissons à la fois la moyenne de l’échantillon et le nombre de points de données. Ainsi, si nous avons les valeurs de tous les points de données sauf un, le dernier point de données ne peut être que la valeur nécessaire pour obtenir cette moyenne spécifique. Par exemple, si nous revenons à notre premier échantillon de 10 professeurs de robotique, et prenons les valeurs des 9 premiers, sachant que la moyenne est de 10,4 et que nous avons échantillonné 10 professeurs de robotique au total, le nombre de robots dans le labo du dernier professeur doit avoir une valeur fixe.

| [latex]\begin{equation} \begin{split} 10.4 =& \frac{1 + 5 + 7 + 10 + 10 + 12 + 12 + 12 + 15 + x}{10} \\ x =& 20 \end{split} \end{equation}[/latex] | (6.74) |

C’est-à-dire que cette valeur de [latex]x[/latex] n’est pas libre de varier. Ainsi, les degrés de liberté sont toujours inférieurs au nombre de points de données dans l’échantillon.

Enfin, après avoir initialement élevé au carré nos valeurs de déviance, nous prenons la racine carrée de l’ensemble de l’équation afin que l’écart type soit toujours exprimé dans les mêmes unités que la moyenne.

Ci-dessous, la formule complète de calcul de l’écart type d’un échantillon. Veuillez noter que si nous devions calculer l’écart-type de la moyenne de la population à la place, la première partie serait remplacée par [latex]\frac{1}{N}[/latex], plutôt que par [latex]\frac{1}{n - 1}[/latex].

| [latex]\begin{equation} s=\sqrt{\frac{1}{n-1}\sum_{i=1}^n(x_i-\bar{x})^2} \end{equation}[/latex] | (6.75) |

En Python, nous pouvons calculer cela en utilisant :

import numpy as np # Importation des bibliotheques

stddev = np.std(data) # Ecart type de echantillon ‘data’

Si nous ne prenons pas la racine carrée de l’équation et la laissons telle quelle, cela s’appelle la variance, noté par [latex]s^2[/latex].

Dans le cadre des tests statistiques, notre intérêt réside dans l’explication des facteurs à l’origine de la variation autour de la moyenne. Dans ce contexte, la moyenne peut être perçue comme un modèle extrêmement simplifié des données, tandis que la variance indique dans quelle mesure ce modèle décrit nos données. Les moyennes présentant une variance élevée sont une représentation peu fiable des données, tandis que celles avec une variance très faible ont de fortes chances d’être une bonne représentation.

La variance d’une variable donnée est composée de deux sources différentes; variance systématique, qui est la variance qui peut être expliquée (potentiellement par une autre variable), et variance non systématique, ce qui est dû à une erreur dans nos mesures.

Nous avons donc souvent, dans nos expériences, plus d’une variable, et nous pourrions être intéressés à décrire la relation entre ces variables – c’est-à-dire que lorsque les valeurs d’une variable changent, les valeurs de l’autre variable changent aussi? Ceci est connu sous le nom de covariance.

La variance totale d’un échantillon à deux variables est alors constituée de la variance attribuée à la variable x, de la variance attribuée à la variable y, et la variance attribuée aux deux. En se souvenant que la variance est simplement le carré de la formule de l’écart type, ou [latex]s^2[/latex], nous pouvons encadrer la somme de la variance totale pour deux variables comme :

| [latex]\begin{equation} (s_x + s_y)^2 = {s_x}^2 + {s_y}^2 + 2s_{xy} \end{equation}[/latex] | (6.76) |

C’est ce dernier terme, [latex]2s_{xy}[/latex] qui nous intéresse, car cela représente la covariance entre les deux variables. Pour calculer cela, nous prenons l’équation de la variance, mais plutôt que de mettre au carré la déviance de [latex]x[/latex], [latex](x - \bar{x})[/latex], nous la multiplions par la déviance de l’autre variable, [latex]y - \bar{y}[/latex]. Cela garantit que nous évitons toujours que les écarts positifs et négatifs s’annulent mutuellement. Ces déviances combinées sont appelées écart de produit vectoriel.

| [latex]\begin{equation} cov(x,y) =\frac{1}{n-1}\sum_{i=1}^n(x_i-\bar{x})(y_i-\bar{y}) \end{equation}[/latex] | (6.77) |

En Python, pour obtenir la covariance entre deux variables, nous pouvons utiliser :

import numpy as np # Importation des bibliotheques

cov = np.cov(data ,ddof=0) #calculer la matrice de covariance

6.7.2 Population générale et échantillons

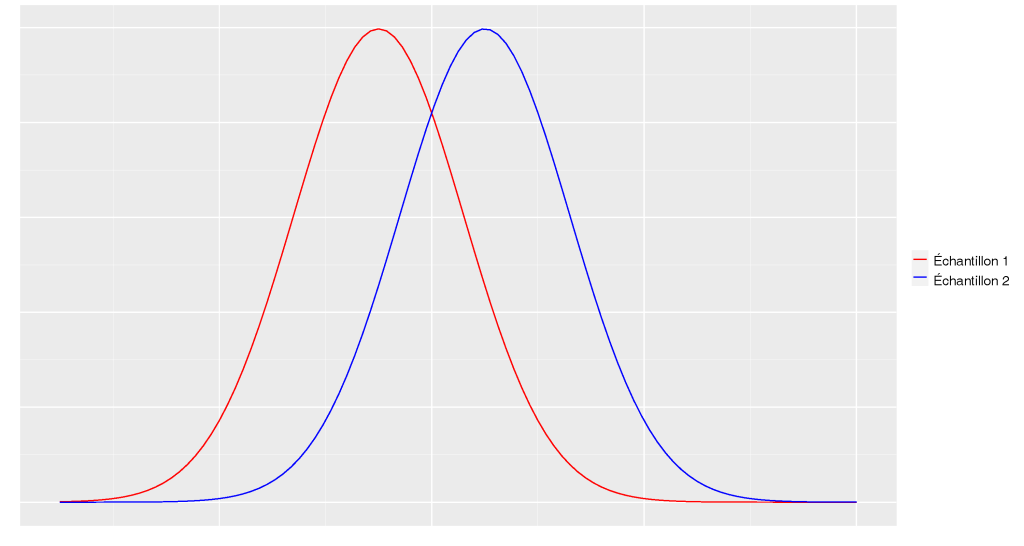

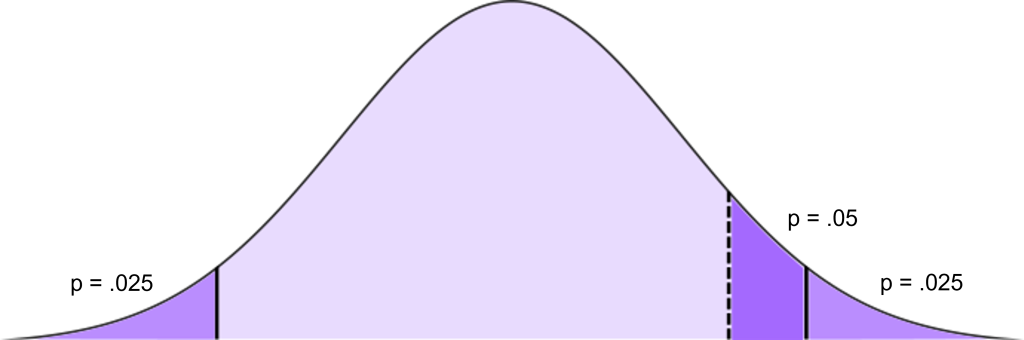

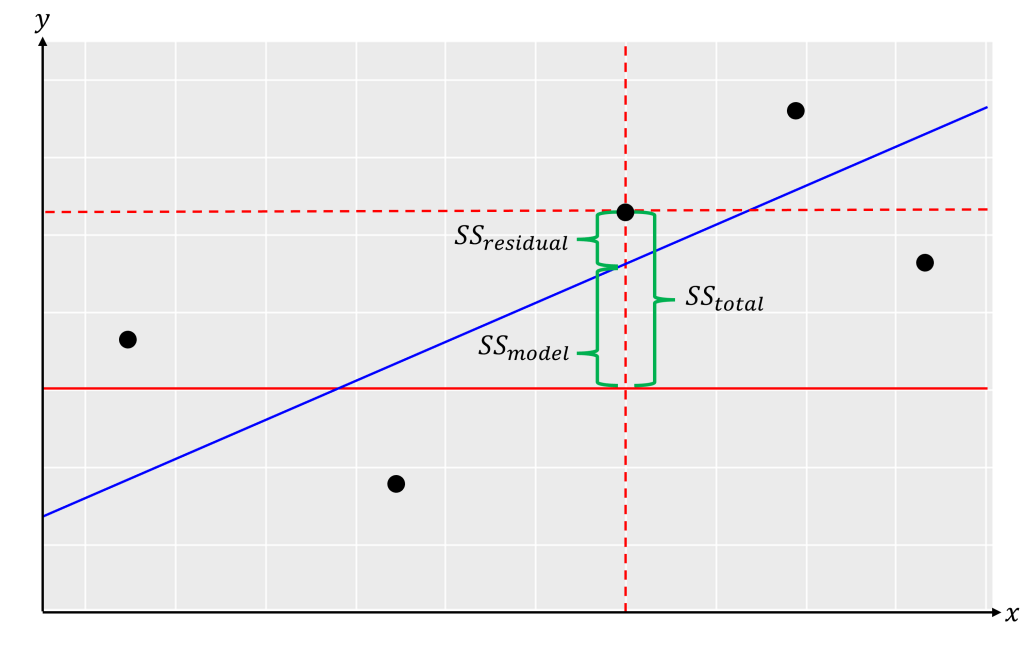

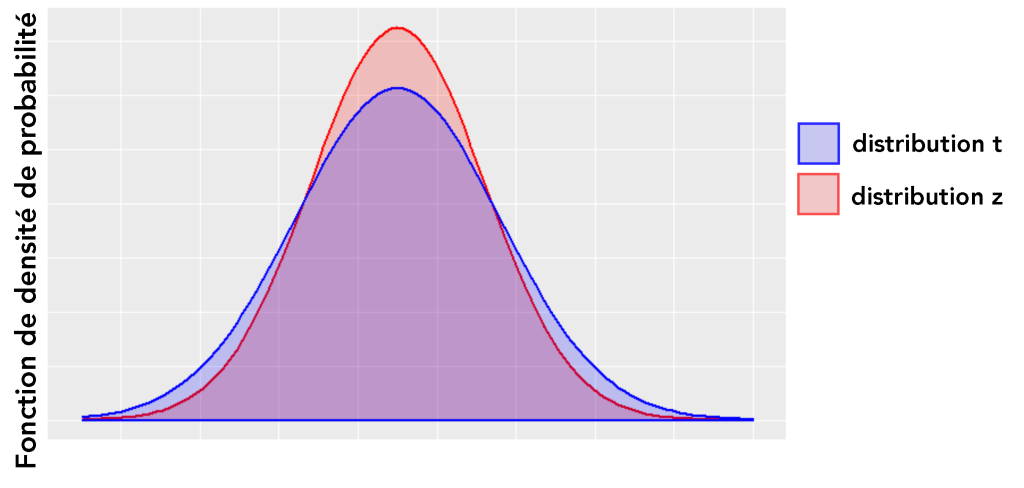

Dans l’exemple mentionné précédemment, nous nous concentrons sur une population spécifique qui suscite notre intérêt : les professeurs de robotique. Cependant, étant donné la difficulté de tester chaque professeur de robotique dans le monde, nous avons choisi un échantillon restreint de professeurs de robotique et leur avons demandé combien de robots ils avaient dans leurs laboratoires. Dans ce cas, le nombre moyen de robots est une estimation de la moyenne de la population générale. Ceci est différent de la véritable moyenne de la population, qui est la moyenne que nous obtiendrions si nous pouvions réellement demander à chaque professeur de robotique combien de robots il possède. Dans un monde idéal, l’échantillon que vous avez collecté serait parfaitement représentatif de l’ensemble de la population, ce qui signifierait que la moyenne de l’échantillon correspondrait à la véritable moyenne. Cependant, étant donné qu’il y a toujours une certaine marge d’erreur associée aux données, il est probable que la moyenne de l’échantillon diffère légèrement de la véritable moyenne.